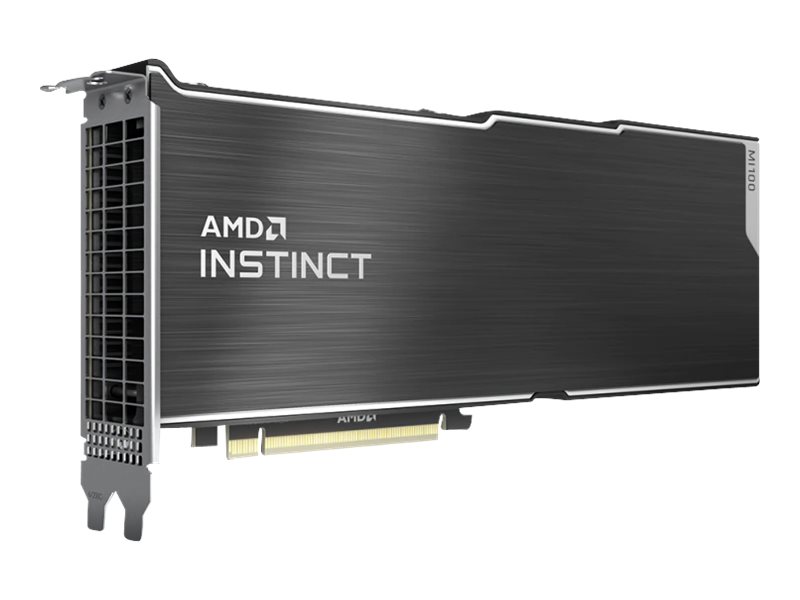

RADEON INSTINCT MI100 32GB

AMD Instinct MI100-acceleratoren er verdens hurtigste HPC-GPU, der er udviklet fra bunden til den nye æra inden for computing. Drevet af AMD CDNA-arkitekturen leverer MI100-acceleratorerne et kæmpe spring i beregnings- og interconnect-ydeevne og tilbyder et næsten 3,5x boost for HPC (FP32-matrix) og et næsten 7x boost for AI (FP16) throughput sammenlignet med tidligere generationer af AMD-acceleratorer.

-

Varenummer 998325480

Model 100-506116

Producent AMD

EAN 0727419416689

Vægt kg

-

Informationer/specifikationer på siden er vejledende og kan uden varsel være ændret af producenten. Der tages forbehold for trykfejl og vejledende billeder.

| Produktbeskrivelse | AMD Instinct MI100 - GPU beregningsprocessor - 32 GB |

| Enhedstype | GPU beregningsprocessor |

| Bus Type | PCI Express 4.0 x16 |

| Hukommelse | 32 GB HBM2 |

| Strømprocessorer | 7680 |

| Effektiv hukommelses clock | 1.2 GHz |

| API-understøttet | OpenCL, OpenMP |

| Dimensioner (B x D x H) | 26.7 cm |

| Generelt | |

|---|---|

| API-understøttet | OpenCL, OpenMP |

| Bus Type | PCI Express 4.0 x16 |

| Egenskaber | Error Correcting Codes (ECC) Memory, FinFET-teknologi, Passive Cooling Solution, 184,6 Tflops spids halv præcision (FP16) ydelse, 23,1 Tflops spids enkelt præcision (FP32) ydelse, 184,6 TOPs INT8 præcisionsydelse, AMD CDNA Architecture, AMD Infinity |

| Enhedstype | GPU beregningsprocessor |

| Strømprocessorer | 7680 |

| Hukommelse | |

| Båndbredde | 1228.8 GBps |

| Effektiv clock hastighed | 1.2 GHz |

| Størrelse | 32 GB |

| Teknologi | HBM2 |

| Systemkrav | |

| Yderligere krav | 2 PCI-pladser |

| Diverse | |

| Dybde | 26.7 cm |

Helt ny Matrix Core-teknologi til maskinlæring

AMD Instinct MI100 GPU giver kunderne den helt nye Matrix Core-teknologi med overlegen ydeevne til et komplet udvalg af blandede præcisionsoperationer, der giver dig mulighed for at arbejde med store modeller og forbedre ydeevnen for hukommelsesbundne operationer til enhver kombination af maskinlæringsworkloads, du har brug for at implementere. MI100 tilbyder optimerede BF16-, INT4-, INT8-, FP16-, FP32- og FP32-matrixfunktioner, der giver dig supercharged beregningsydelse for at opfylde alle dine AI-systemkrav. AMD Instinct MI100 håndterer store data effektivt til træning af komplekse neurale netværk, der bruges i deep learning, og leverer et næsten 7x boost for AI (FP16) performance sammenlignet med AMD's tidligere generation af acceleratorer.

AMD Infinity Fabric Link-teknologi

AMD Instinct MI100 GPU'er giver avancerede I/O-funktioner i standard servere med Infinity Fabric-teknologier og PCIe Gen4-understøttelse. MI100 GPU'en leverer 64 GB/s CPU til GPU-båndbredde uden behov for PCIe-switche og op til 276 GB/s peer-to-peer (P2P) båndbreddeydelse gennem tre Infinity Fabric Links designet med AMD's 2. generations Infinity-arkitektur.

AMD's Infinity-teknologier gør det muligt

platformdesign med to direkte forbundne quad GPU-hives, der muliggør overlegen P2P-forbindelse og leverer op til 1,1 TB/s samlet teoretisk GPU-båndbredde i et serverdesign.

Ultrahurtig HBM2-hukommelse

AMD Instinct MI100 GPU giver 32 GB HBM2-hukommelse med høj båndbredde ved en clockfrekvens på 1,2 GHz og leverer en ultrahøj ~1,2 TB/s hukommelsesbåndbredde for at understøtte dine største datasæt og hjælpe med at eliminere flaskehalse ved flytning af data ind og ud af hukommelsen. Kombiner denne ydeevne med MI100's avancerede I/O-funktioner, og du kan skubbe workloads tættere på deres fulde potentiale.

Branchens nyeste PCIe Gen 4.0

AMD Instinct MI100 GPU er designet til at understøtte den nyeste PCIe Gen 4.0-teknologi, som giver op til 64 GB/s teoretisk båndbredde for transportdata fra CPU til GPU pr. kort.

Førende FP64-ydeevne til HPC-arbejdsbelastninger

AMD Instinct MI100 GPU leverer brancheførende dobbeltpræcisionsydelse med op til 11,5 TFLOPS peak FP64-ydelse, hvilket gør det muligt for videnskabsfolk og forskere over hele verden mere effektivt at behandle parallelle HPC-koder på tværs af flere brancher, herunder biovidenskab, energi, finans, akademikere, regering, forsvar og meget mere.